「大數據已死。」

說這話的,正是來自Google十年員工,數據分析產品BigQuery創始成員之一,Jordan Tigani。

在最新發布的一篇博文中,他表示——

大數據概念在十多年前開始興起,時至今日,銷售們仍用「海量數據帶來指數級增長曲線」說法,來勾起(唬住)客戶為相關服務買單的欲望,否則就將被數字時代拋棄。作者自己也曾是其中之一。

但現在,Jordan Tigani不僅認為這種說法行不通,還稱——「數據大小根本不是問題所在。」

那麼問題在哪?他認為,我們已無需擔心數據大小,而應專注於如何使用數據來做出更好的決策。

如此言論之下,也吸引了不少業內人士的圍觀和熱議。

他的上述觀點有何依據?

不妨從證明過程看起。

值得注意的是,作者表示,證明過程中相關圖表曲線並不是嚴格參考了數據,而是憑記憶手繪的,這位資深從業者強調——重要的是曲線形狀趨勢,而非確切數值。

「恐嚇」客戶的話術出問題了

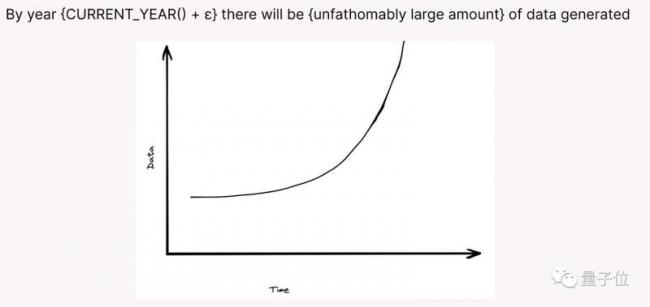

Jordan Tigani先從一張PPT聊開去。

這是一條數據量隨時間增長,呈現指數級增長的曲線,在過去十年,幾乎每個大數據產品推銷都從該曲線開啟。他曾就職的谷歌、SingleStore都不例外。

但Jordan Tigani認為,多年來的事實已證明,處理數據的老方法已經行不通了,且大多數應用程式也不需要處理大量數據。

一個佐證是近些年傳統架構的數據管理系統復興,諸如SQLite、Postgres、MySQL都增長強勁,與之對比,「NoSQL」甚至「NewSQL」增長卻停滯不前。

一個明顯例子是MongoDB,它是排名最高的NoSQL類資料庫,也同樣是最火的橫向擴展類資料庫,此前幾年MongoDB增長勢頭強勁,但最近規模卻小幅下降,且與MySQL等主流資料庫仍存差距。

Jordan Tigani認為——如果大數據真是未來,那情況應該不一樣。

鼓吹大數據時代就在眼前的另一個說法是——每個人都會被產生的數據淹沒。

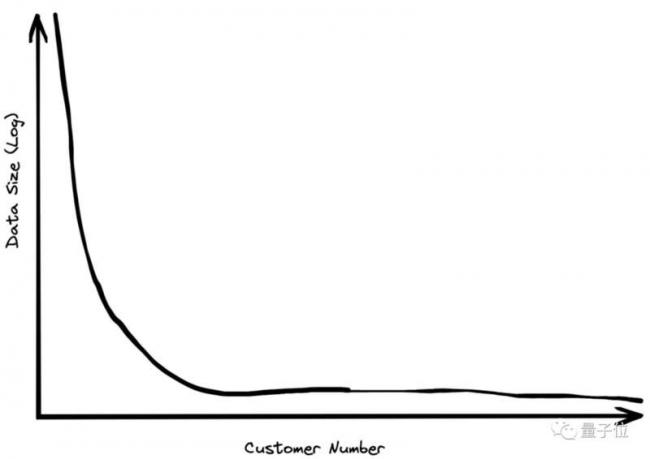

但Jordan Tigani在研究客戶中發現絕大多數客戶總數據存儲量不超過1TB,即便大型企業,其數據量級也soso。

根據他的從業經驗,所服務的最大客戶數據存儲量是第二大客戶的2倍,第二大客戶又是第三位的2倍。

這樣一來,客戶數據大小與數量服從冪律分布。

只有極少數客戶擁有PB級數據,成千上萬客戶每月存儲費用不超過10美元,而他們服務客戶存儲資源使用的中位數,連100GB都不到。

不僅作者本人這麼認為,Gartner、Forrester等機構分析師及其他從業者也表示,大部分企業的資料庫量級都小於1TB,且100GB是常態。

拿一家超千名客戶的公司舉例,即便每個客戶每天下一個訂單,裡面包含100項數據,每天生成數據仍小於1位元組,三年後是1GB,而要達到1TB,這家公司得做幾千年生意。

另一個例子是之前作者接觸了一家E輪獨角獸公司,且還在快速成長中,但即便這樣,他們的財務數據、客戶數據、營銷跟蹤數據及服務日誌加起來,也只有幾GB。

就這,能叫大數據?

還不算完,即便看「已有」部分,也有問題。

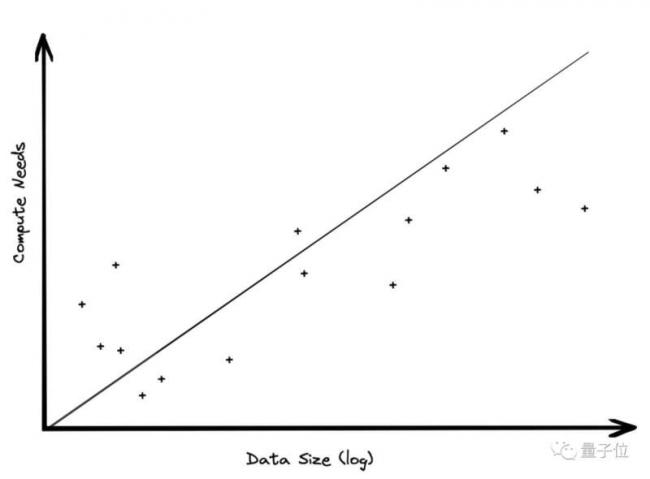

由於現代雲平台將存儲與計算分開,兩部分利用量級也有很大差距,即——數據存儲增長速度,遠大於計算資源需求增速。

具體來說,企業數據的存儲量隨時間推移,肯定是線性增加的,但大部分分析計算需求是針對近期數據,不可能一遍又一遍反覆讀取舊數據。因此,計算需求不會同步迅速增加。

Jordan Tigani的一個客戶就是這樣。

作為全球頭部零售商,他們原有100TB本地數據,遷移到雲上後,數據量變成了30PB,增加了300倍,如果計算資源需求也隨之拉滿,那他們在數據分析上的花費將達幾十億美元,但事實上,他們只花了很小一筆費用。

作者認為,大量計算服務不被需要,也就意味著前沿架構不太有必要,甚至分布式處理也Duck不必。

與之類似,分析數據的工作負載也遠小於數據體量。

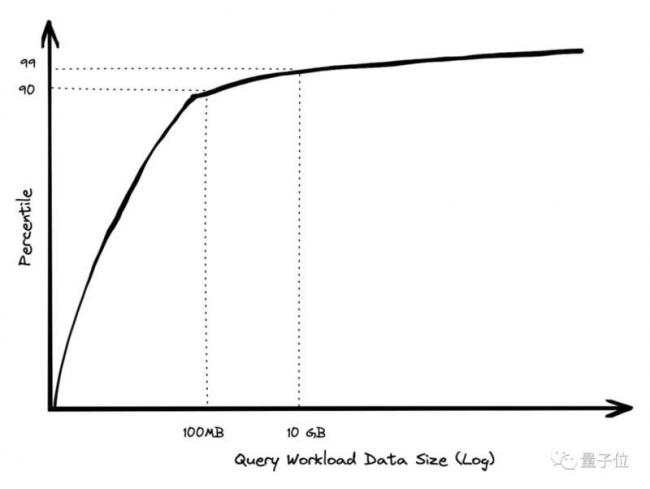

多數時候,人們往往只會查詢前1小時、前1天或上周數據,較小的表會被頻繁查詢,但大表就不一定了。

在作者本人BigQuery工作經歷中,數據量巨大的客戶幾乎從不查詢大量數據,除非他們正在生成一些報告。

這種需求,也不要求性能優先,且僅是企業一周幾十萬個查詢中的極少數。

正如下圖,90%查詢任務涉及的數據量級不超過100MB,僅1%超過10GB,且即便查詢巨型表,資料庫也可通過一定處理,減少計算量和延遲。

一個側面佐證是——業內符合原本「大數據」定義的產品也在變少。

在當初,大數據的定義之一是「任何單機無法處理相關任務/場景需求」,比如00年代,數據工作負載對於單個商業計算機來說,帶不動是常態。

但今天,一個AWS的標準實例所用到的物理伺服器包含了64核及256GB RAM,如果為優化實例再多掏一點錢,又能在原基礎上增加2個數量級RAM,這幾乎覆蓋所有工作負載需求。

既然大數據時代結束了,那是不是說,相關從業者要下崗了?

作者也提出了自己的看法——

結束了,但沒完全結束。

具體來說,作者認為,大數據的另一重內涵是「當數據保存的支出小於其挖掘價值,那就應該放棄」,因而,我們需要判定哪些數據需要及時清除,以及背後的原因,這將成為數據工作的重要部分。

這當中,也包括不同時期同一數據以不同欄位存儲,需要有人來加以維護和留有記錄。

此外,基於相關監管規定,很多類型數據(比如涉及個人隱私的電話號碼)也需要定期清除。

再有,便是一些公司需要定期判斷哪些舊數據要清理,以避免未來可能的法律風險。(手動狗頭)

ChatGPT老闆有不同看法

對於Jordan Tigani上述觀點及論證,有網友表示支持,還聯想到之前類似的工作經歷。

也有網友表示:

當XX已死,說明它真實被認可的地方會被保留下來。

值得一提的是,並非所有人都贊同作者的觀點。

尤其鑑於「XX已死」將話說得太滿,有網友認為:

在近期AI大火之際,判決AI所依賴的大數據已死,也是挺敢說。

當紅炸子雞ChatGPT背後老闆Sam Altman,此前在舊金山一次技術活動中,也談過對大數據的看法,Sam認為——

AI研究領域取得令人印象深刻的進步,不僅依靠海量數據,同時更需要海量的計算。

上述觀點不僅強調了海量數據重要性,對比Jordan Tigani所認為的「重存儲輕計算」看法,正好相反。

另一個不同聲音來自一位名叫Lewis Gavin的大數據與軟體工程師,此前他曾在Medium上發文,主題也是圍繞「大數據是否消亡」

他認為:

大數據不會死,只會變得更重要。

所給出理由是:一方面依據是全球生成的數據總量仍在加速增長,且細分領域中,處理「大數據」正成為常態。

基於此,Lewis Gavin認為——所謂「大數據死亡」,只是營銷說法的消亡,但Big Data處理技術和應用仍存在,且它會成為習以為常的現象。

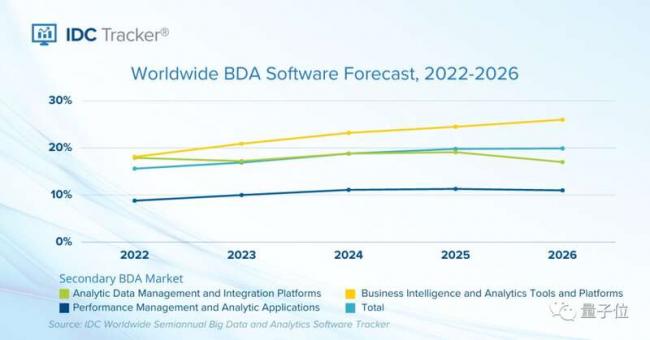

IDC於1月24日發布的一篇預測證明了大數據市場仍在增長,內容指出——

未來幾年,全球大數據和分析軟體市場將實現強勁增長,且具體到該板塊各細分領域,未來幾年增長率均為雙位數。

有意思的是,有網友提出「大數據的死亡」並不是個技術話題。

他表示:數據之所以沒發揮價值,其實是商界精英們往往忽略數據內蘊藏的結論。

另一位網友也表示贊同,還稱:

自己曾開玩笑,數據科學家的工作其實不是搞分析,而是為高管們前瞻性觀點提供有力證明。(手動狗頭)