大模型就是「造夢機」!幻覺是LLM與生俱來的特性,而非缺陷。OpenAI科學家Andrej Karpathy獨特視角在AI社區掀起了激烈的討論。

幻覺,早已成為LLM老生常談的問題。

然而,OpenAI科學家Andrej Karpathy今早關於大模型幻覺的解釋,觀點驚人,掀起非常激烈的討論。

在Karpathy看來:

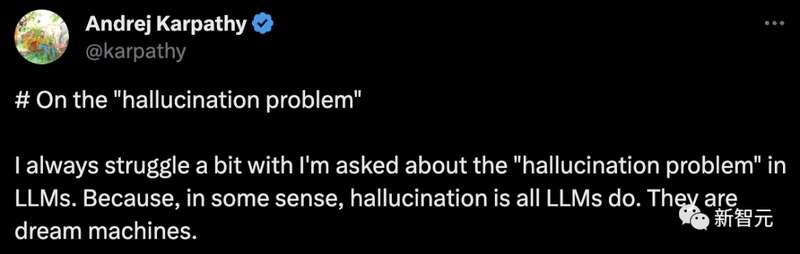

從某種意義上說,大語言模型的全部工作恰恰就是製造幻覺,大模型就是「造夢機」。

另外,Karpathy的另一句話,更是被許多人奉為經典。他認為,與大模型相對的另一個極端,便是搜尋引擎。

「大模型100%在做夢,因此存在幻覺問題。搜尋引擎則是完全不做夢,因此存在創造力問題」。

總而言之,LLM不存在「幻覺問題」。而且幻覺不是錯誤,而是LLM最大的特點。只有大模型助手存在幻覺問題。

對此,英偉達高級科學家Jim Fan分享了自己的看法,「令人著迷的是,最好的LLM可以通過切換到『工具使用模式』來『決定』何時做夢,何時不做夢。網絡搜索是一種工具。LLM可以動態調整自己的『dream%超參數』。GPT-4試圖做到這一點,但遠非完美」。

亞利桑那州立大學的教授Subbarao Kambhampati也跟帖回復了Karpathy:

LLM一直在產生幻覺,只是有時他們的幻覺碰巧和你的現實一致而已。

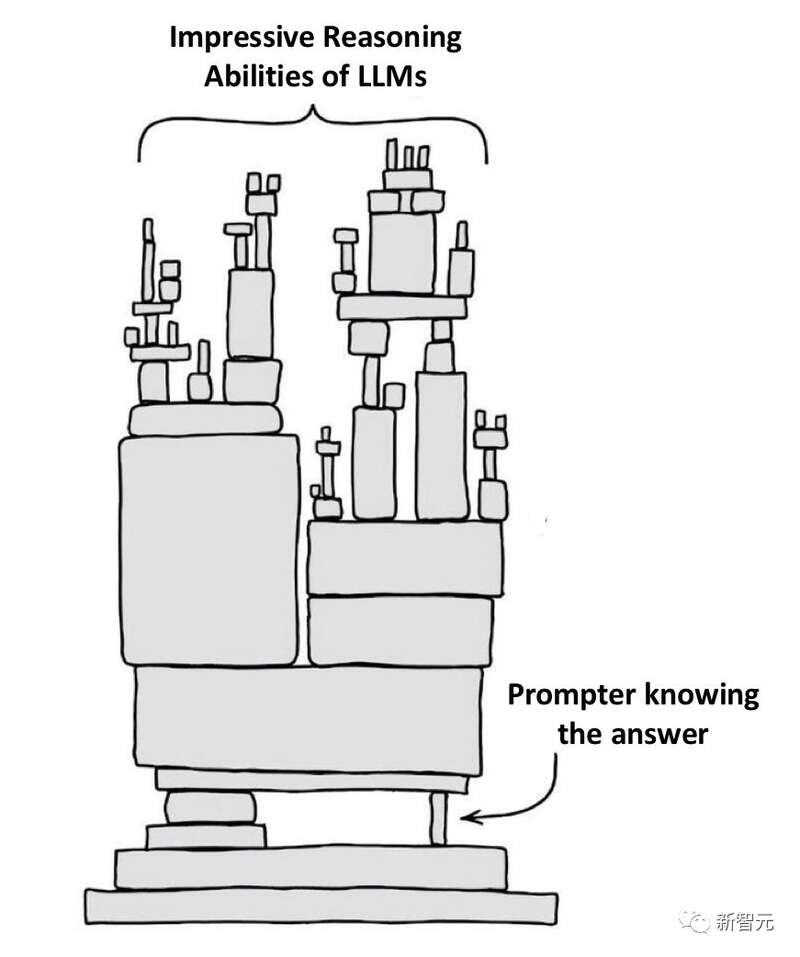

而提問者是否能夠讓幻覺和自己的現實一致,很大程度取決於提問者自己對產生內容的檢查能力。

基於這個認知,他認為,所有想要將LLM的能力擬人化的嘗試都只是人類的一廂情願,將思考、想法、推理和自我批評等擬人化概念強加在LLM上都是徒勞的。

人類應該在認清LLM能力的本質基礎之上,將它當作一個「補充人類認知的矯正器」,而不是潛在的替代人類智能的工具。

當然,討論這種問題的場合永遠少不了馬老闆的身影:「人生不過就是一場夢」。

感覺下一句他就要說,我們也只是生活在矩陣模擬之中

Karpathy:LLM不存在「幻覺問題」,LLM助手才有

對於大模型飽受詬病的幻覺問題,Karpathy具體是如何看的呢?

我們用「提示」來引導這些「夢」,也正是「提示」開啟了夢境,而大語言模型依據對其訓練文檔的模糊記憶,大部分情況下都能引導夢境走向有價值的方向。

只有當這些夢境進入被認為與事實不符的領域時,我們才會將其稱為「幻覺」。這看起來像是一個錯誤,但其實只是LLM本就擅長的事情。

再來看一個極端的例子:搜尋引擎。它根據輸入的提示,直接返回其資料庫中最相似的「訓練文檔」,一字不差。可以說,這個搜尋引擎存在「創造力問題」,即它永遠不會提供新的回應。

「大模型100%在做夢,因此存在幻覺問題。搜尋引擎則是完全不做夢,因此存在創造力問題」。

說了這麼多,我明白人們「真正」關心的是,不希望LLM助手(ChatGPT等產品)產生幻覺。大語言模型助手遠比單純的語言模型複雜得多,即使語言模型是其核心。

有很多方法可以減輕AI系統的幻覺:使用檢索增強生成(RAG),通過上下文學些將做夢更準確回溯在真實數據上,這可能是最常見的一種方法。另外,多個樣本之間的不一致性、反思、驗證鏈;從激活狀態中解碼不確定性;工具使用等等,都是熱門且有趣的研究領域。

總之,雖然可能有些吹毛求疵,,但LLM本身不存在「幻覺問題」。幻覺並非是缺陷,而是LLM最大的特點。真正需要解決幻覺問題的是大語言模型助手,而我們也應該著手解決這一問題。

LLM是造夢機,請停止一廂情願的「擬人化」

來自亞利桑那州立大學的AI科學家Subbarao Kambhampati教授,把自己的研究總結成了一篇X上的長文。

他認為產生不同的認知(包括幻覺)就是LLM本質能力,所以不應該對於LLM產生過於理想化的期待。

連結地址:

https://twitter.com/rao2z/status/1718714731052384262

在他看來,人類應該將LLM視為強大的認知「模擬器」,而不是人類智能的替代品。

LLM本質上是一個令人驚嘆的巨大的外部非真實記憶庫,如果使用得當,可以作為人類強大的認知「模擬器」。

而對於人類來說,想要發揮LLM的作用,關鍵是如何有效地利用LLM,而不是在這個過程中不斷用擬人化的企圖來自欺欺人。

人類對於LLM最大的錯覺就是我們不斷地將LLM與人類智能相混淆,努力地將思考、想法、推理和自我批評等擬人化概念套在LLM之上。

這種擬人化是相當徒勞的——而且,正如很多研究中展現的那樣——甚至會適得其反並具有誤導性。

而從另一個角度說,如果我們不將「通過LLM開發出達到人類水平的AI系統」設定為唯一目標,就不用天天批判自回歸LLM非常差勁(比如LeCun教授)。

LLM是可以非常有效地補充認知的「模擬器」,並沒有天然包含人類的智力。

LLM在某些事情上能比人類做得好太多了,比如快速概括,歸納總結。

但是在做很多其他事情的能力上比人類又差太多了,比如規劃、推理、自我批評等。

人類真正需要的也許是:

1.充分利用LLM的優勢。這可以在LLM產品架構中加入人類或者其他具有推理能力的工具來強化LLM的優勢。

2.在某種程度上,人類水平的智能仍然是目前值得追尋的聖杯,保持開放的研究途徑,而不是僅僅是堆疊算力,擴大自回歸架構。

大模型幻覺,究竟從何來

前段時間,一個名為Vectara的機構,在GitHub推出了一個大模型幻覺排行榜。

結果顯示,在總結短文檔方面,GPT-4的表現最為優異,而Google PaLM的兩款模型直接墊。

其中,GPT-4的準確率為97.0%,幻覺率為3.0%,回答率為100.0%。Palm-Chat2的準確率為72.8%,幻覺率高達27.2%,回答率為88.8%。

不過,這個榜單一出來,受到了許多業內人士的質疑。

OpenAI聯合創始人兼研究員John Schulman曾在一次演講——「RL和Truthfulness– Towards TruthGPT」,探討了幻覺問題。

根據Schulman的說法,幻覺大致可以分為兩種類型:

-模型猜測錯誤

-模式完成行為:語言模型無法表達自己的不確定性,無法質疑提示中的前提,或者繼續之前犯的錯誤。

語言模型代表一種知識圖譜,其中包含來自其自身網絡中訓練數據的事實,因此「微調」可以理解為學習一個函數,該函數在該知識圖譜上運行並輸出token預測。

舉個例子,微調數據集可能包含「星球大戰屬於什麼類型影片」這個問題,以及答案「科幻」。

如果這些信息已經在原始訓練數據中,即它是知識圖譜的一部分,那麼模型不會學習新信息,而是學習一種行為——輸出正確答案。這種微調也被稱為「行為克隆」。

但是,如果答案不是原始訓練數據集的一部分(也不是知識圖譜的一部分),即使網絡不知道答案,它便會學習回答。

使用實際上正確但不在知識圖譜中的答案進行微調,從而教會網絡編造答案——即產生「幻覺」。相反,用不正確的答案進行訓練會導致網絡隱瞞信息。

網友激烈探討

「LLM是一個造夢機」。多麼美妙的一句話。如果我們人類也生活在更高維度創造者構造的夢境中,那麼LLM將來是否也能遞歸地創造出做夢的機器?

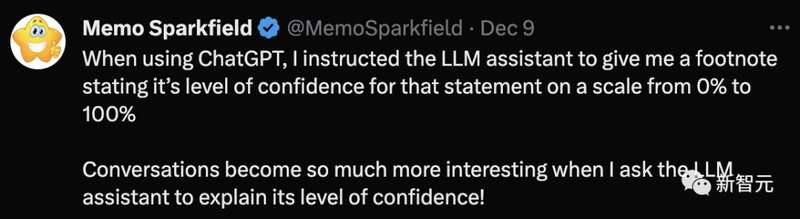

另一位網友分享了他要求ChatGPT給自己的回覆進行置信度評分時,ChatGPT給了90%,並且解釋了原因:

我在回復末尾提供的置信度是一個估計值,反映了根據我所掌握的上下文和信息,我認為回復與您的詢問的吻合程度。它不是通過精確的算法或公式計算出來的,而是根據問題的複雜性、所提供信息的清晰度以及我對所能獲取信息的準確性和相關性的編程進行的主觀評估。

其實對於幻覺的討論本質上就是對於「真理」的討論,也許並沒有什麼東西是絕對客觀的「真理」。

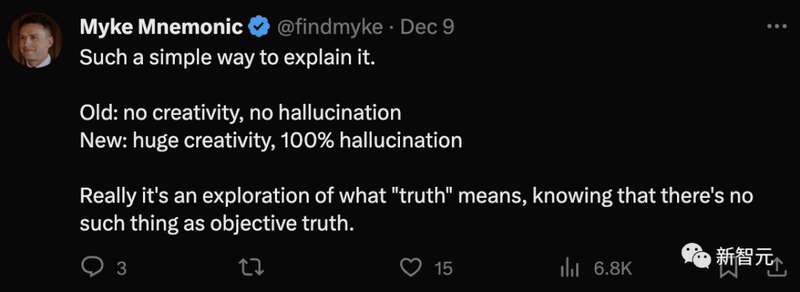

當所需數據已經存可用時,並不總是需要搜索事實。然而,LLM面臨的挑戰在於其學習過程,這通常涉及一種「破壞性」數據壓縮。解決這個問題——減少數據丟失,不僅能緩解幻覺問題,還能減少對大量訓練數據集的需求。

事實上,我們的最終目標不僅僅是創造更多的LLM,而是實現真正的智能。雖然LLM通過語言理解提供了一瞥,但它們的根本缺陷是學習過程損害了數據完整性。理想的架構應該是在學習過程中保留數據,保持對原始信息的忠實,同時還能讓模型發展和完善其智能。我假設這樣的架構可能涉及複製數據而不是壓縮數據。

每個LLM都是一個不可靠的敘述者,就其架構的本質而言,它是不可逆轉的。