隨著ChatGPT引發新一輪人工智慧(AI)熱潮,而其背後帶來的能耗問題也持續引發關注。

今年4月10日,晶片巨頭 Arm公司CEO哈斯(Rene Haas)公開表示,包括ChatGPT在內的 AI大模型需要大量算力,預計到2030年,AI數據中心將消耗美國20%至25%的電力需求,相比今天的4%大幅增加。

公開數據顯示,目前,ChatGPT每天需要處理超過2億次請求,其電量消耗高達每天50萬千瓦時。一年時間,ChatGPT光電費就要花2億元人民幣。

這意味著,ChatGPT日耗電量是普通家庭的1.7萬倍以上。(美國商業用電一度約為0.147美元也就是1.06元,相當於一天53萬元)

據荷蘭諮詢機構負責人Alex de Vries預計,到2027年,AI行業每年將消耗850億~1340億千瓦時的電力,相當於瑞典或荷蘭一個歐洲國家一年的總用電量。

馬斯克判斷,電力缺口最早可能會在2025年發生,「明年你會看到,我們沒有足夠電力來運行所有的晶片」。

OpenAI CEO奧爾特曼(Sam Altman)也預計,AI行業正在走向能源危機,未來 AI技術發展將高度依賴於能源,人們也需要更多的光伏和儲能產品。

這一切都顯示出,AI即將引爆全球新一輪「能源戰爭」。

不止是晶片,AI還被能源「卡脖子」

過去500多天裡,ChatGPT引發全球新一輪 AI大模型和算力需求熱潮。

微軟、谷歌、Meta、OpenAI等多家全球科技巨頭開始瘋搶 AI晶片,甚至親自下場「造芯」,總規模超過數十萬億元美金。

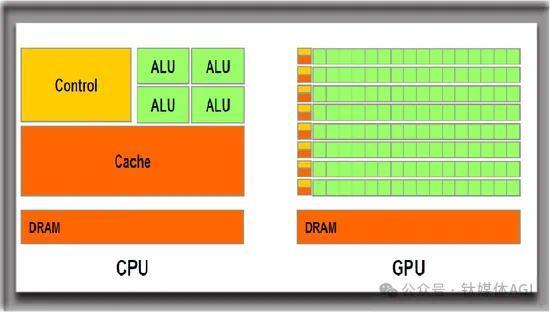

實際上,AI本質上是一種計算機技術和處理信息的技術,背後則需要大量GPU晶片,更底層則是大量電能、水力、風能、資金等資源的支持。

早在1961年,在IBM公司工作的物理學家拉爾夫·蘭道爾(Rolf Landauer)發表了一篇論文,提出了後來被稱為「蘭道爾原理」(Landauer's Principle)的理論。

這一理論認為,計算機中存儲的信息發生不可逆的變化時,會向周圍環境散發一點點熱量,其散發的熱量和計算機當時所處的溫度有關——溫度越高,散發的熱量越多。

蘭道爾原理連接起了信息和能量。更具體地說,它連接到了熱力學第二定律上。因為邏輯上不可逆的信息處理操作,也就意味著湮滅了信息,這會導致物理世界中熵的增加,從而消耗能量。

這一原理自提出以來遭受過不少質疑。但近十幾年來,「蘭道爾原理」已被實驗證明。

2012年,《自然》雜誌發表了一篇文章,研究團隊首次測量到了一「位」(bit)數據被刪除時釋放的微量熱量。後來的幾次獨立實驗,也都證明了「蘭道爾原理」。

過去10多年間,現代電子計算機在計算時實際消耗的能量,是蘭道爾理論值的數億倍。而科學家們一直在努力尋找更高效的計算方法,以降低成本。

如今,AI大模型爆發,它確實需要大量計算。因此,AI不止被晶片「卡脖子」,還被能源「卡脖子」。

馬斯克近期也在「博世互聯世界2024」大會上表示,一年多以前,短缺的是晶片,明年你會看到電力短缺,無法滿足所有晶片的需求。

中國科學技術信息研究所人工智慧中心副主任李修全也表示,近年來, AI大模型規模、數量都在高速增長,也帶來對能源需求的快速增加。儘管短期內還不會很快出現「缺電」等問題,但未來大規模智能化時代來臨後的能源需求激增不容忽視。

AI大模型質量的關鍵在於數據、算力和頂尖人才,而高算力的背後,是靠招數萬張晶片晝夜不停的運轉支撐。

具體來說,AI模型算力的工作過程大致可以分為訓練、推理兩個階段,能源消耗也是如此。

其中,在AI訓練階段,首先需要收集和預處理大量的文本數據,用作輸入數據;其次,在適當的模型架構中初始化模型參數,處理輸入的數據,嘗試生成輸出;最後,通過輸出與預想之間的差異反覆調整參數,直到模型的性能不再顯著提高為止。

從訓練15億參數的GPT-2,到訓練1750億參數的GPT-3,OpenAI模型背後的訓練能耗十分驚人。公開信息稱,OpenAI每訓練一次需要128.7度電,相當於3000輛特斯拉同時跑32公里。

據研究機構New Street Research估計,僅在AI方面,谷歌就需要大約40萬台伺服器,每天消耗62.4吉瓦時,每年消耗22.8太瓦時的能源。

而在推理階段,AI則會先加載已經訓練好的模型參數,預處理需要推理的文本數據,再讓模型根據學習到的語言規律生成輸出。谷歌稱,從2019年到2021年,AI相關能源消耗60%都來自推理。

據Alex de Vries估算,ChatGPT每天大概要響應大約2億個請求,耗電量超過50萬度,按照一年電費就是2億元人民幣,比每個美國家庭的平均日用電量高1.7倍。

SemiAnalysis報告稱,使用大模型進行問題搜索所消耗的能源是常規關鍵詞搜索的10倍。以谷歌為例,標準谷歌搜索使用0.3Wh電力,而大模型每次互動的耗電量為3Wh。如果用戶每次在谷歌搜索都使用AI工具,每年大約需要29.2太瓦時的電力,也就是每天約7900萬度。這相當於給全球最大的摩天大樓,杜拜的哈利法塔,連續供電超過300年。

另據斯坦福人工智慧研究所發布的《2023年 AI指數報告》顯示,每次 AI搜索的耗電量大約為8.9瓦時。相比普通谷歌搜索,加入 AI的單次耗電量幾乎是一般搜索的30倍。而一個高達1760億參數的模型,光是前期訓練階段就得用掉了43.3萬度電,相當於美國117個家庭一年的用電量。

值得注意的是,在Scaling Law(縮放規律)之中,隨著參數規模不斷躍升,大模型性能也不斷提升,而對應的是,能耗也會越來越高。

因此,能源問題已經成為 AI技術持續發展的關鍵「桎梏」。

GPT每天消耗50000升水,電和水是 AI兩大能源需求

AI不僅是「耗電狂魔」,更是「吞水巨獸」。

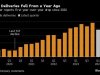

其中,在電力方面,除了上述信息外,據國際能源署(IEA)數據顯示,2022年,全球數據中心消耗約460太瓦時的電量(相當於全球總需求的2%),隨著生成式AI飛速發展,這一數字到2026年可能膨脹至620至1050太瓦時。

Alex de Vries預計,到2027年,AI伺服器所消耗的用電量將等同於荷蘭全國的能源需求量。最壞的情況就是,僅谷歌一家公司的AI就可以消耗與愛爾蘭等國家一樣多的電力。

IBM高級副總裁達里奧·吉爾曾表示,「AI能耗」是非常重要的挑戰。生成式 AI的高性能伺服器的持續運行,將導致數據中心一半以上的電力消耗都被AI占據。據悉,預計到2025年,AI業務在全球數據中心用電量中的占比將從2%猛增到10%。

那麼,水能呢?大模型背後需要數據中心、雲基礎設施的支持,那就需要大量的「液冷」進行散熱。

德克薩斯大學的一份研究指出,作為ChatGPT背後的重要支持力量,微軟的Microsoft Azure雲數據中心光是訓練GPT-3,15天就用掉將近70萬升的水,相當於每天花銷約50000L水。

同時,ChatGPT每回答50個問題就要消耗500毫升水。公開信息稱,2022年微軟用水量達到640萬立方米,比2500個奧林匹克標準游泳池的水量還多。

美國加州大學河濱分校副教授任紹磊團隊預計,到2027年,全球AI可能需要4.2-66億立方米的清潔淡水量,這比4-6個丹麥、或二分之一的英國的一年取水總量還要多。

除了數據中心,內置的GPU晶片也是能源消耗的重點領域之一。今年3月,英偉達發布史上性能最強AI晶片——Blackwell GB200,宣稱是A100/H100系列AI GPU的繼任者,性能相比H100提升30倍,但能耗卻降低了25倍。

上個月,黃仁勛的一句「AI的盡頭是光伏和儲能」更是在網絡瘋傳。儘管有網友扒出原視頻稱,黃仁勛本人並未說過這句話,更沒有提及「光伏和能源」,但 AI能耗嚴重,卻是擺在公眾面前的事實。

國際能源機構(IEA)在一份報告中強調了這個問題,全球 AI數據中心的耗電量將是2022年的十倍,並指出部分原因在於 ChatGPT這樣的大模型所需的電力,遠高於谷歌等傳統搜尋引擎。

不過,值得注意的是,由於科技巨頭們並未正式披露過 AI使用中的電力消耗數據,因此,目前關於 AI耗電量的數據多為估算,並不一定是非常準確的數據。美國資訊技術與創新基金會(ITIF)曾指出,個別不準確的研究高估了AI能耗。AI訓練是一次性事件,它的使用是長期過程。人們應關注 AI能耗的長期影響,並非爆發式增長。

有專家認為,目前大模型訓練成本中60%是電費,能源開支已經嚴重製約著大模型的疊代升級。

金沙江創投主管合伙人朱嘯虎近日也表示,可控核聚變實現前,我們並沒有足夠的算力實現真正的AGI。幫人類降低90%的工作可能未來3到5年可以實現,但最後的10%可能需要大量的算力和能耗。

如何解決 AI能耗之困?硬體優化和核聚變或是重要手段

雖然黃仁勛也非常擔憂能源供給,但他卻給出了一個更樂觀的看法:過去10年,AI計算提高了100萬倍,而它消耗的成本、空間或能源並未增長100萬倍。

美國能源情報署發布的長期年度展望中估計,美國目前電力需求的年增長率不到1%。而按新能源公司NextEra Energy CEO約翰•凱徹姆(John Ketchum)的估計,在 AI技術的影響下,這一電力需求年增長率將加快至1.8%左右。

波士頓諮詢集團的報告則顯示,2022年,數據中心用電量占美國總用電量(約130太瓦時)的2.5%,預計到2030年將增加兩倍,達到7.5%(約390太瓦時)。這相當於約4000萬個美國家庭的用電量,即全美三分之一家庭的用電量。該集團還預計,生成式 AI將至少占美國新增用電量的1%。

這意味著,即使數據中心、AI新增用電量並不小,但還遠不到毀天滅地的地步。

而在成本方面,國際可再生能源署報告指出,過去十年間,全球風電和光伏發電項目平均度電成本分別累計下降超過了60%和80%。上述業界人士也介紹說,「光伏的綜合成本跟火電差不多,風電一半區域的綜合成本比火電低了。」

因此,隨著 AI技術一路狂飆,我們又將如何應對即將到來的能源需求熱潮?

鈦媒體App根據一些行業專家的觀點總結來看,目前解決 AI能耗問題有兩種方案:一是可以通過大模型或AI硬體優化降低能耗;二是尋找新的能源,比如核聚變、裂變資源等,以滿足AI能耗需求。

其中,在硬體優化方面,對於能耗較高的萬億級 AI大模型,可以通過算法和模型優化,壓縮模型token大小及複雜度,以降低能源消耗規模;同時,企業也可以持續開發和更新能耗更低的 AI硬體,如最新的英偉達B200,AI PC或AI Phone終端等;此外,通過優化數據中心的能效,提高電源使用效率,以降低能源消耗。

對此,中國企業資本聯盟副理事長柏文喜表示,未來,還需要進行技術創新和設備升級,以進一步提高發電效率、提高電網輸送能力和穩定性、優化電力資源配置、提高電力供應的靈活性、推廣分布式能源系統並減少能源輸送損耗,以此來應對算力發展帶來的能源需求挑戰。

中國數據中心工作組(CDCC)專家委員會副主任曲海峰認為,相關行業應該要重視提升數據中心用電能效,而不是抑制它的規模。數據中心並非要減少對能源的消耗,而是要提升能源消費的質量。

而在開發核聚變能源方面,由於可控核聚變由於原料資源豐富、釋放能量大、安全清潔、環保等優勢,能基本滿足人類對於未來理想終極能源的各種要求。

核聚變的能量來源目前主要有三種:宇宙能源,即太陽發光發熱;氫彈爆炸(不受控核聚變);人造太陽(受控核聚變能源裝置)。

據統計,當前世界共有50多個國家正在進行140餘項核聚變裝置的研發和建設,並取得一系列技術突破,IAEA預計到2050年世界第一座核聚變發電廠有望建成並投入運行。

這種核聚變發電,將大大緩解全球因 AI大模型需求造成的能源短缺情況。

2023年4月,奧爾特曼就「未雨綢繆」,以個人名義向核聚變初創公司Helion Energy投資3.75億美元(約合人民幣27.04億元),並擔任公司董事長。同時,去年7月,奧特特曼還通過旗下公司AltC與其投資的核裂變初創公司Oklo合併,斬獲了一個估值約為8.5億美元(約合人民幣61.29億元)的IPO,ALCC最新市值超過400億美元。

除了奧爾特曼這種重金投資核聚變公司,亞馬遜、谷歌等科技巨頭則直接大手筆採購清潔能源。

據彭博數據顯示,僅在2023年,亞馬遜就購買了8.8GW(吉瓦)的清潔能源電力,已經連續第4年成為全球最大的企業清潔能源買家。Meta(採購3GW)和谷歌(採購1GW)等科技公司則位列其後。

亞馬遜稱,其90%以上的數據中心電力都來源於清潔能源產生的電力,預計能在2025年實現100%使用綠色電力。

實際上,以美國為例。清潔能源、AI、數據中心、電動汽車、挖礦等多種產業的增長,讓原本陷入停滯的美國電力需求再度「起飛」。但即使被譽為世界上「最大的機器」,美國電網也似乎無法應對這突如其來的變化。

有分析師指出,美國70%的電網接入和輸配電設施已老化,某些地區電網傳輸線路不足。因此,美國電網需要大規模升級,如果不採取行動,到2030年美國將面臨一道難以逾越的國內供應缺口。

相對於美國,中國則對能源需求表達樂觀態度。「AI再耗電,中國的體量和能力足以支撐,現在不進行大規模開發,是因為沒需求。」一位風電行業人士表示,中國可規劃的容量足夠大,AI要是有大量電力需求,我現在就能上項目當中去工作。

目前,中國風電、光伏產品已經出口到全球200多個國家和地區,累計出口額分別超過334億美元和2453億美元。

隨著 AI呈現爆發式增長,這場中美 AI產業角逐,已經從大模型技術比拼,升級成為一場算力、能源、人力等多方位爭奪戰。

隨著核聚變能源或將到2050年落地,人類期望終結 AI能耗這一具有挑戰性難題,進入無限發電時代。