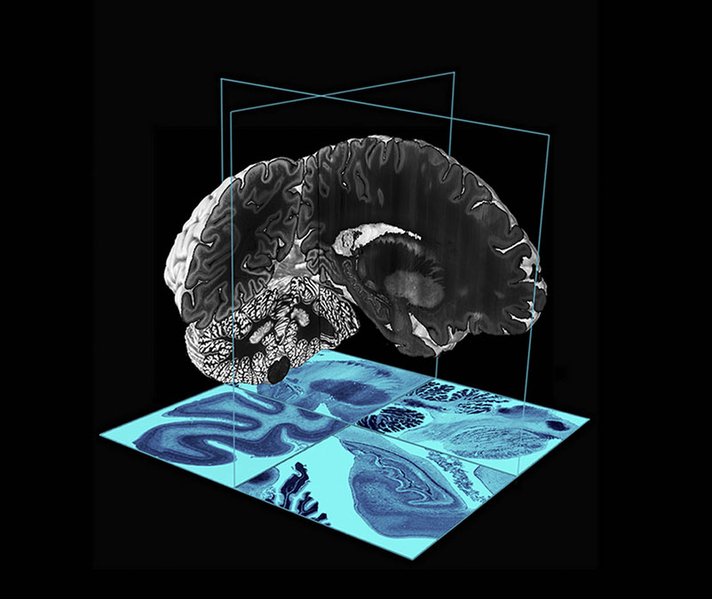

圖為示意圖。麥吉爾大學教授、大腦研究學者阿蘭·伊萬斯(Alan Evans)和他的研究團隊研發出一種新的大腦3D數位顯示模型圖,可提供的數據集比傳統的核磁共振成像方式要高12.5萬倍。與本文無關。

根據周一(5月1日)發表在《自然神經科學》雜誌上的一項經同行評議的研究,科學家已經開發出一種非侵入性的人工智慧(AI)系統,它可以「讀取」人的大腦活動,並將其翻譯成文本流。

這個人工智慧系統被稱為語義解碼器(Semantic Decoder)。它最終可以使那些因中風、癱瘓或其它退化性疾病而失去交流能力的患者受益。

德克薩斯大學奧斯汀分校(University of Texas at Austin)的研究人員,通過使用轉換器模型(transformer model)開發了該系統。該模型與支持谷歌的聊天機器人Bard,以及OpenAI公司的聊天機器人ChatGPT的人工智慧模型類似。

該人工智慧系統不需要進行植入手術。該研究通過讓實驗參與者在功能性磁共振成像(fMRI)掃描器內聽幾個小時的播客,並對其大腦活動進行解讀,來訓練人工智慧大腦活動解碼器。功能性磁共振成像掃描器是一種可以檢測大腦內部情況的、昂貴的大型機器。

一旦人工智慧系統接受了訓練,它就可以在實驗參與者聽或想像一個故事時,根據其大腦活動進行解碼,並生成一個文本流。目前所解碼的大腦思維文本,並非全部大腦思維的精確的記錄。研究人員在現階段設計它的目的,是為了能夠捕捉大腦中一段想法或觀點。

根據一份新聞稿,經過訓練的人工智慧系統,對實驗參與者的大腦思維進行解碼後所產生的文本,達到與實驗者思維內容非常接近或精確匹配水平的比例,已經達到了大約一半。

例如,在實驗中,當參與者聽到「我還沒有駕照」這句話時,其大腦中的想法會被人工智慧翻譯成:「她甚至還沒有開始學習駕駛。」

據美國全國廣播公司財經頻道(CNBC)報導,這項研究的負責人之一的亞歷山大·休斯(Alexander Huth)在新聞稿中表示:「對於一個非侵入性的方法來說,與以前所做的工作相比,這個系統是一個真正的飛躍。以前的工作通常只能解碼單字或短句。我們正在讓這個人工智慧模型繼續學習,以便能夠長時間地、對複雜的想法進行連續的語言解碼。」

新聞稿說,該研究的成果還包括,當實驗參與者在掃描器中觀看四個沒有音頻的視頻時,人工智慧系統已經能夠通過其大腦活動,準確地描述他多看到的「某些事件」。

截至周一,這個人工智慧語義解碼器還不能夠在實驗室環境之外使用,因為它仍依賴於功能性磁共振成像掃描器。但研究人員相信,它最終可以通過可攜式腦成像系統來使用。

該研究的主要研究人員,已經為該技術申請了PCT專利。