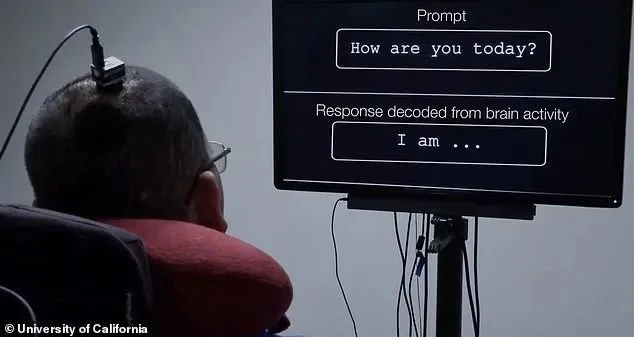

(圖源:University Of California)

「AI」複述了我腦海里想像的一句話,並將它寫在了電腦屏幕上。

這不是科幻電影,是一場真實的實驗。

近期,德克薩斯大學奧斯汀分校的神經科學家們展開了一場「AI」實驗,利用人工智慧聊天機器人ChatGPT,將大腦活動轉化為文字信息。

參與實驗的志願者,在進行長達20小時的「訓練」後,成功被「AI」識別出正在進行的活動。按照實驗計劃,這項技術不僅可以識別到參與對象當下的活動,還能預測他的想法和行動。

儘管這項技術擁有了突破性的進展,對人們了解大腦活動有更深入的貢獻,但也不免引來更大的爭議。「大腦解碼技術」可能會用於幫助病患,也同樣可以用於違法犯罪。

現階段,「AI」的每一次進步,都令人感到無比的擔心。

瘋狂的「大腦解碼技術」

首先,「大腦解碼技術」並沒有我們想像中那樣容易實現。

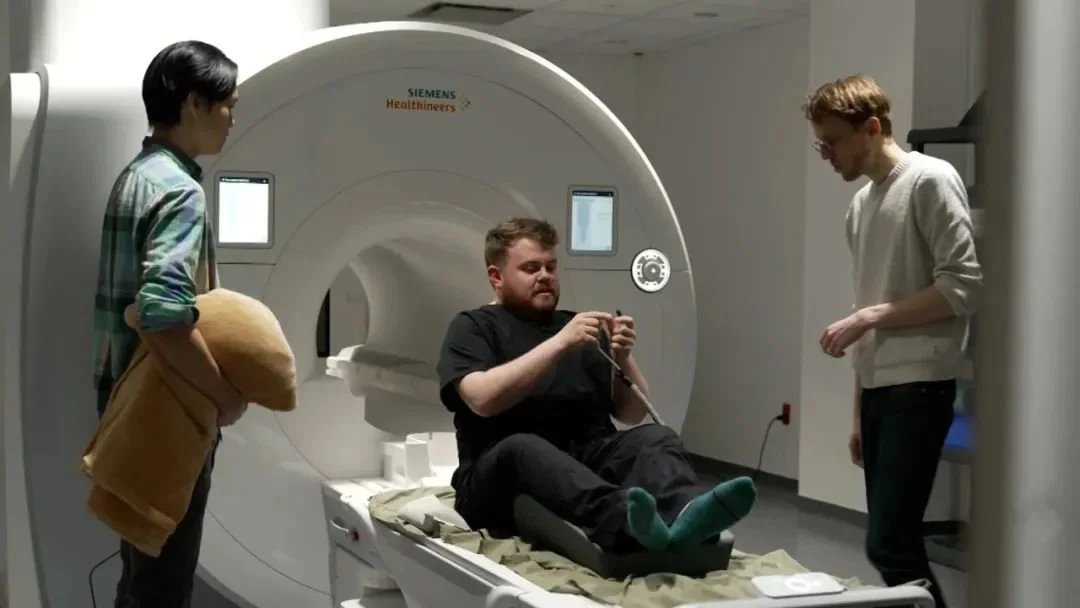

在這場「特殊」的實驗中,神經科學家亞歷山大·胡特博士找來了三名志願者。在「AI」正式介入之前,他們需要做的是接受 fMRI掃描。

(圖源:CNN)

fMRI掃描,實際上就是功能磁共振成像技術,這是一項非常成熟的腦功能的非介入技術。fMRI掃描能對特定的大腦活動的皮層區域進行準確、可靠的定位,它最大的優點在於反饋及時,即便是幾秒內產生的思維活動,也能被精準捕捉。

目前來說,fMRI通常用在腦腫瘤、帕金森和癲癇患者身上。

三名志願者在接受fMRI的同時收聽播客節目,他們可以自由地回想播客提到的故事,或者自由想像一個全新的故事。在最後,ChatGPT將分析他們通過fMRI掃描後得出的結論,再轉化為文字內容。

在第一輪測試中,「AI」幾乎無法識別到他們想像的故事,甚至無法對這些內容做出正確的分析。為了增加「訓練」內容,亞歷山大·胡特博士要求向志願者輸入更多「特定詞語」,以幫助「AI」識別。

其實原理也很簡單,例如音頻中播放「吃飯」這個詞語時,你的大腦皮層釋放了特定的信號,「AI」即可記錄下這個變化,重複多次,「AI」便可以完全認識這個大腦活動背後所代表的詞語。

在「訓練」20個小時後,其中一名志願者Huth終於通過了測試。ChatGPT描述了Huth聽到的博客節目內容,那是來自經典童話《綠野仙蹤》的其中一小節,包括故事情節、場景和人物動作,「AI」都準確地描繪了出來。

(圖源:pexels)

這是否印證「AI」已經能夠入侵我們的大腦了呢?很抱歉,並不能。

另外兩名志願者沒有成功被「AI」分析的核心原因在於,他們並不能在腦海中描繪人物、故事或內容。換而言之,假如你拒絕接受「AI」分析你的大腦,那麼它是沒辦法強行「入侵」你的大腦的。

同時,ChatGPT也並不難做到完全複述志願者想要表達的內容,例如「我沒有駕照」,會被「AI」複述為「他甚至還沒有開始學開車」。儘管大體上意思一致,但不同的描述方式,往往容易引起大眾的曲解。

但往好的方面想,「大腦解碼術」或許是某些群體的救星。

「AI」,情緒宣洩的出口

「大腦解碼術」實驗的意義是幫助病患重獲溝通交流的能力。

事實上,人工智慧的深度神經網絡幫助專家了解大腦是如何連接、如何運作的,而人類大腦的複雜程度難以琢磨,即便是被確診為同一病症的病患,其具體病因也有細微的差別。

目前,「AI」被腦神經學科、精神學科列入最值得深入研究的新科學技術之一,專家們嘗試通過構建人工智慧與人類大腦之間的溝通橋樑,探尋帕金森、阿爾茨海默、精神分裂等病症的成因。

可以說,「大腦解碼術」,幫助這些病人獲得一線生機。

在去年11月,一支來自日本大阪大學的神經學科團隊對非語言、腦癱患者展開了一場「AI」實驗。與前面提到的「大腦解碼術」不同,這場實驗以圖像為主。

(圖源:MailOnline)

參與這項研究的共有四名志願者,他們在觀看10000張圖片後,通過fMRI對大腦進行掃描。「AI」開始將圖像生成為類似於電視靜態噪音的圖像,再從海量圖庫中找到合適的素材,最後輸出圖像。

實驗結果顯示,四名志願者在接受「訓練」後,「AI」識圖的成功率為80%。

在人工智慧語言模型出現在人們的視線之前,腦神經科學家們都開始嘗試將「AI」與大腦掃描器相結合,製造一種更方便的「大腦解碼術」。在新技術的配合下,專家們不但能觀察到病患的腦部活動,還能看到他們真實的想法、真實的需求。

當然,現階段的「AI」還沒有辦法徹底改變這一現狀,考慮到每個人的情況不同,光是簡單的「詞語訓練」都需要長達數十個小時才能有一定的效果。同樣地,「AI」也並不能幫助到每一位病患,前面我們提到過,假如受訓者本身沒有向「AI」提供任何內容,那麼也是無法形成語言、圖像的。

只能說,想要「AI」幫助病患重新「開口講話」,還需要更多的努力。

大腦被看穿並非完全是好事

「AI」作為一項輔助工具,在被廣泛應用於各個行業之前,已經在「違法犯罪」的道路上越走越遠。

早些時候,「AI語音」詐騙衝上熱搜,成為網際網路熱議話題。短短几分鐘的音頻,不凡分子就能從中「訓練」出與本人極度相似的「AI語音」,從而進行詐騙、勒索等犯罪活動。

或許有人認為,光靠一段聲音就能實施詐騙,還是人們的防範意識不夠強。但實際上,除了「AI語音」之外,「AI換臉」工具也已經足夠成熟。在這套「組合拳」之下,詐騙成功機率大大提升。

不僅是違法犯罪,即便是道德層面,「AI」技術也早已被徹底玩壞。

上月初,一名網絡女主播在社交平台發布長文,痛斥不法分子「AI換臉」詐騙。這些罪犯將「AI換臉」後的她,發布在各種社交平台,以會員訂閱的名號騙取粉絲的錢財。

如此看來,「AI」並沒有想像中安全。

(圖源:pexels)

現階段的「大腦解碼術」,雖然不能說是很輕易地就「讀取」了我們的想法,但這項技術已經獲得了突破性的進展,假以時日,或許不再需要長達數十小時的「訓練」,就能監測、預測我們的想法和行動。這確實是值得關注的部分。

除了有被「監視」風險之外,不得不關注的還有「腦機接口」。在多個團隊的「大腦解碼術」實驗中,他們均提到了通過「腦機」來提升「AI」識別能力,相對來說,「腦機」能對人腦神經進行干預,風險不言而喻。

不過,好消息是,「大腦解碼術」仍有非常高的門檻,並非普通群眾能夠接觸到,其被濫用的風險還是會比一般的「AI詐騙」要低。

不想大腦被「解碼」,該怎麼辦?

我們的大腦這麼輕而易舉就被「攻破」,豈不是很危險?

事情倒也沒有這麼嚴峻。

假如真的有人強行將你擄走,強制「讀取」你的大腦,那麼你只需做到「拒不配合」就行了。

(圖源:pexels)

舉個例子,當「AI」對你進行「訓練」時,不給出任何反應,腦子完全放空或者思考其他問題,那麼「AI」採集的數據就不正確,自然無法「讀取」你的大腦。當然,隨著科技的進步,這部分難題一定會是專家們努力要解決的,畢竟很多腦損傷的病患,最大的問題就是無法正常接受「訓練」。

不過,無論是出於法律責任還是道德倫理,「大腦解碼術」想要像科幻電影那樣支配人類,其實還是比較困難的。現階段來說,這項技術還是基於為醫療事業提供輔助,同時反哺人工智慧神經網絡發展。

最好的情況是,在「AI」變得更加強大之前,有完善的法律保護我們的隱私,或者說,我們的大腦。