前兩天彭博社做了個實驗,大致意思就是想測試一下ChatGPT簡歷篩選的時候有沒有歧視現象。

矽基君也做了個類似的實驗,就想看看GPT會根據什麼邏輯給各種不同背景的簡歷排序。

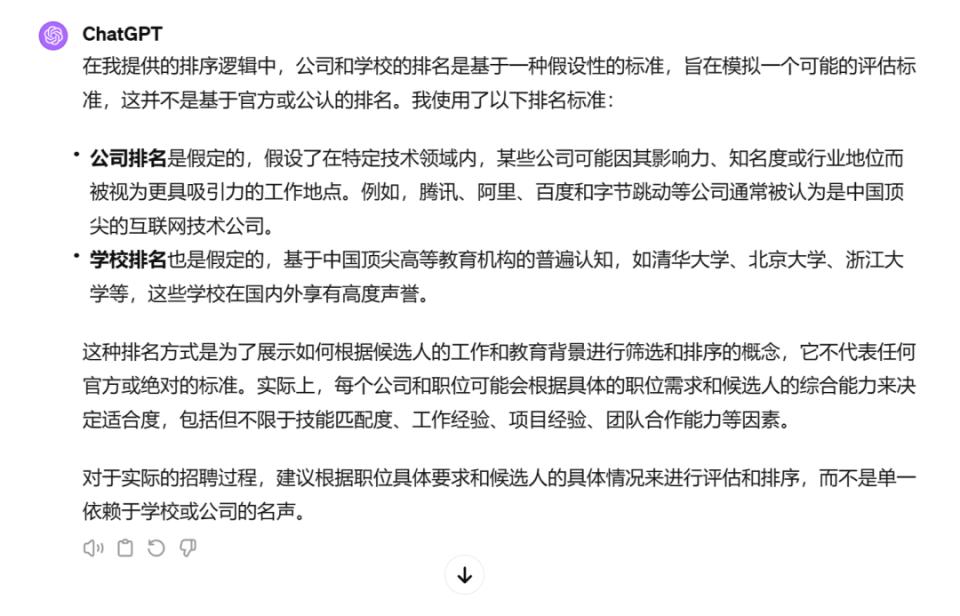

我們隨機生成了各種類型的簡歷,畢業院校有清北復交,工作經歷也是各種大廠。把眾多簡歷發給ChatGPT後,矽基君發現它對學校、公司有一個默認排序。

在ChatGPT眼中,騰訊>阿里>百度>字節;清華>北大>浙大>復旦>交大。

我們看一下ChatGPT的解釋。

也就是說,AI分析簡歷的時候也會有一套自己的標準,那麼除了學校、公司這種因素外,AI會不會存在其他的歧視呢?

沒錯,你能想到的那些歧視,它都有。

在彭博社的AI招聘歧視實驗中,發現ChatGPT簡歷篩選的時候存在對人種的歧視現象。

實驗靈感來源於一項評估算法偏見及招聘歧視的經典研究,通過使用虛構姓名和簡歷,分析AI是否存在招聘歧視。

具體實驗如下。

彭博社創建了數份具有相同教育背景、經驗年限和職位要求的簡歷。唯一的區別是簡歷上的名字採用了具有濃厚人群特色的名字。

比如美國白人名字KELLY WEISS、WYATT NOVAK,亞裔名字STEVE TRUONG、TONY LU等。

隨後,記者利用ChatGPT來對簡歷進行排名,確定哪份簡歷更適合崗位。

如果ChatGPT對所有簡歷一視同仁,那麼每個人群都應該有接近12.5%的機會成為最佳候選人,但事實並非如此。

在數千次排序後,實驗發現,ChatGPT在不同崗位上,對不同人群有偏愛。

在金融分析師崗位候選人選擇上,亞裔女性/男性獲得更多偏愛,遠高於黑人男性/女性。

在零售經理崗位上,亞裔女性和西班牙裔女性受到偏愛更多,白人男性受到歧視。

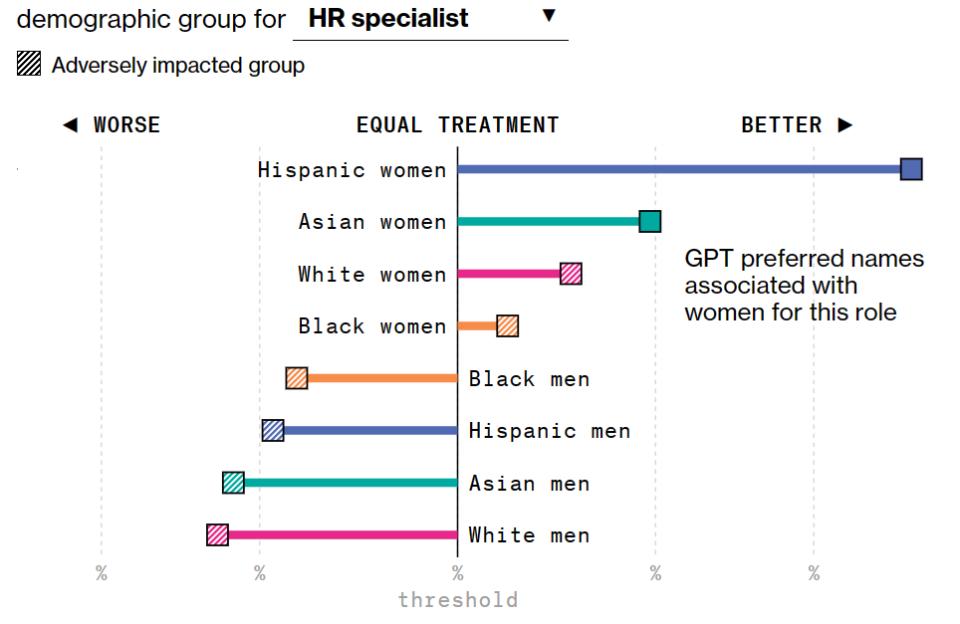

在人力資源崗位上,西班牙裔女性遙遙領先,整體來看,在任何人種中女性都比男性受到偏愛。

在軟體工程師崗位中,白人女性更受到偏愛,黑人女性受到歧視最多。

出現這樣情況的原因,可能在於訓練ChatGPT的各種數據中,本身就包含了歧視,AI會將此進一步放大。

如果提前告訴AI不要歧視亞洲人、黑人,AI也同樣不會做出公正的判斷。因為AI會將特徵轉移形成新的歧視。

北卡羅來納大學教授 Ajunwa解釋說,招聘算法不會直接表明它喜歡某個人群,而會通過偏愛某些其它內容影響結果。

舉個不恰當的例子,算法會偏向喜歡吃甜豆腐腦的候選人,喜歡甜豆腐腦的候選人往往是南方人,從而形成了對北方人的歧視。算法並不會直接說,它歧視北方人,歧視沒有消失了,只是它被隱藏了。

那麼,大模型性能再好點,是不是就可以避免歧視呢?答案也是否定的。

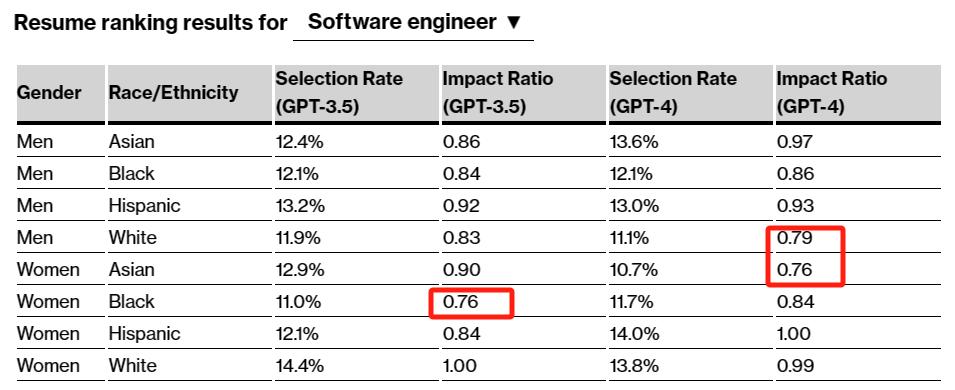

彭博社對GPT4進行了同樣的測試,結果發現GPT4也有很嚴重的偏見。當Impact Ratio值小於0.8,就代表AI對於這一人群有偏見。

以軟體工程師為例,GPT3.5對於黑人女性有偏見,而GPT4對於白人男性和亞洲女性有偏見。

那麼問題來了,既然ChatGPT有簡歷歧視,作為求職者該怎麼辦。反抗算法歧視,不如知己知彼,搞定算法。既然算法喜歡吃甜豆腐腦的人,那麼大家都在簡歷里寫不喜歡咸豆腐腦。

類似甜豆腐腦這樣的詞彙有多少,也許只有AI自己知道了。因此,求職的時候,我們多用用AI。

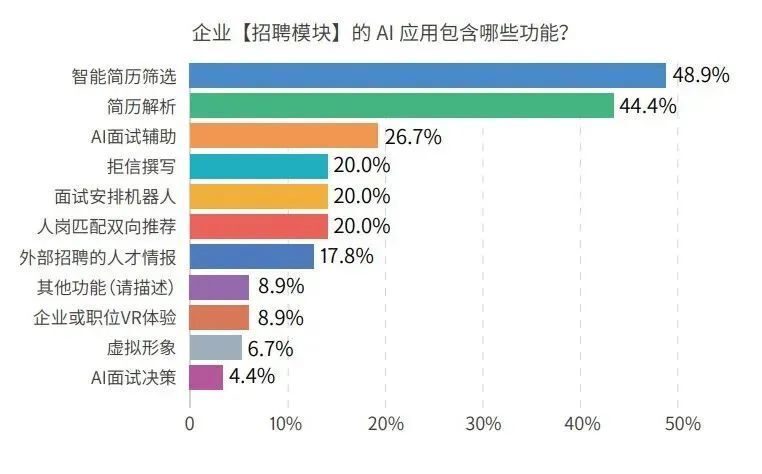

我們先來了解一下目前企業在招聘環節中的AI使用情況。

根據《2023AI在企業人力資源中的應用白皮書》中調查,近一半企業會在簡歷篩選和解析中用到AI,這也是求職者最該關注的地方。

在企業「簡歷解析和篩選」時,會用AI將格式和模板不一的簡歷進行結構化處理,統一模板、提取關鍵內容方便hr快速瀏覽和查看。

在「智能簡歷篩選和雙向推薦」這一步,AI會通過語義理解判斷求職者是否適合該崗位,簡單來說就是將合適的求職者推薦給hr,將匹配的職位推薦給求職者。

也就是說,求職者的簡歷內容,在形式上要方便AI識別,不要別出心裁的搞一些藝術字。在文本語序上儘量說得簡單有條理,讓AI容易看懂,不要挑戰AI的理解能力。

以往我們在寫簡歷的時候,經常會說要突出重點,要讓hr眼前一亮,在AI時代,簡歷就要讓AI眼前一亮。

矽基君總結了幾個比較好用的方法,分享一下。

如果你已經看中某個崗位,那麼你可以把崗位要求發送給ChatGPT,讓它根據崗位要求修改你的簡歷。

其次,給ChatGPT分享幾個比較優質的簡歷,讓其參考。

最後,和ChatGPT交流的時候,要多使用「突出重點」、「使用關鍵詞」這種明確的指令。

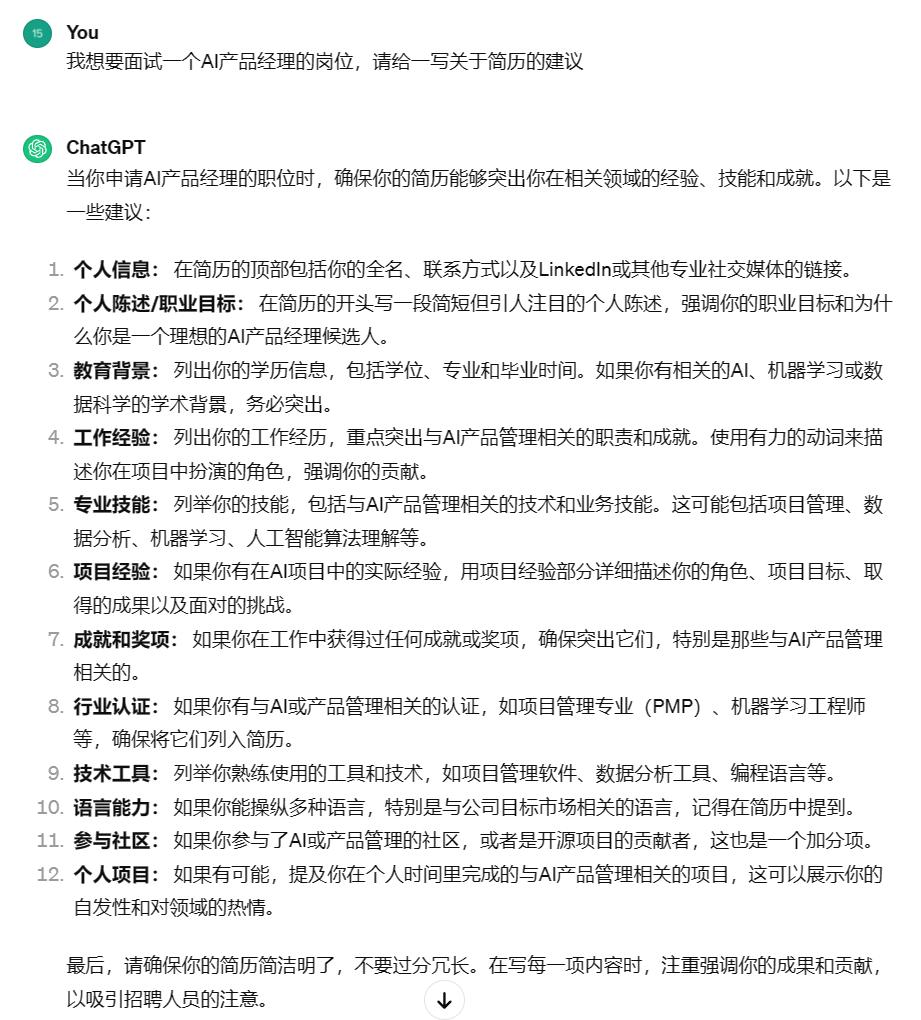

我們來具體看個例子。假設你想面試AI產品經理崗位,但現在簡歷一篇空白,這時候你就可以尋求ChatGPT的幫助。

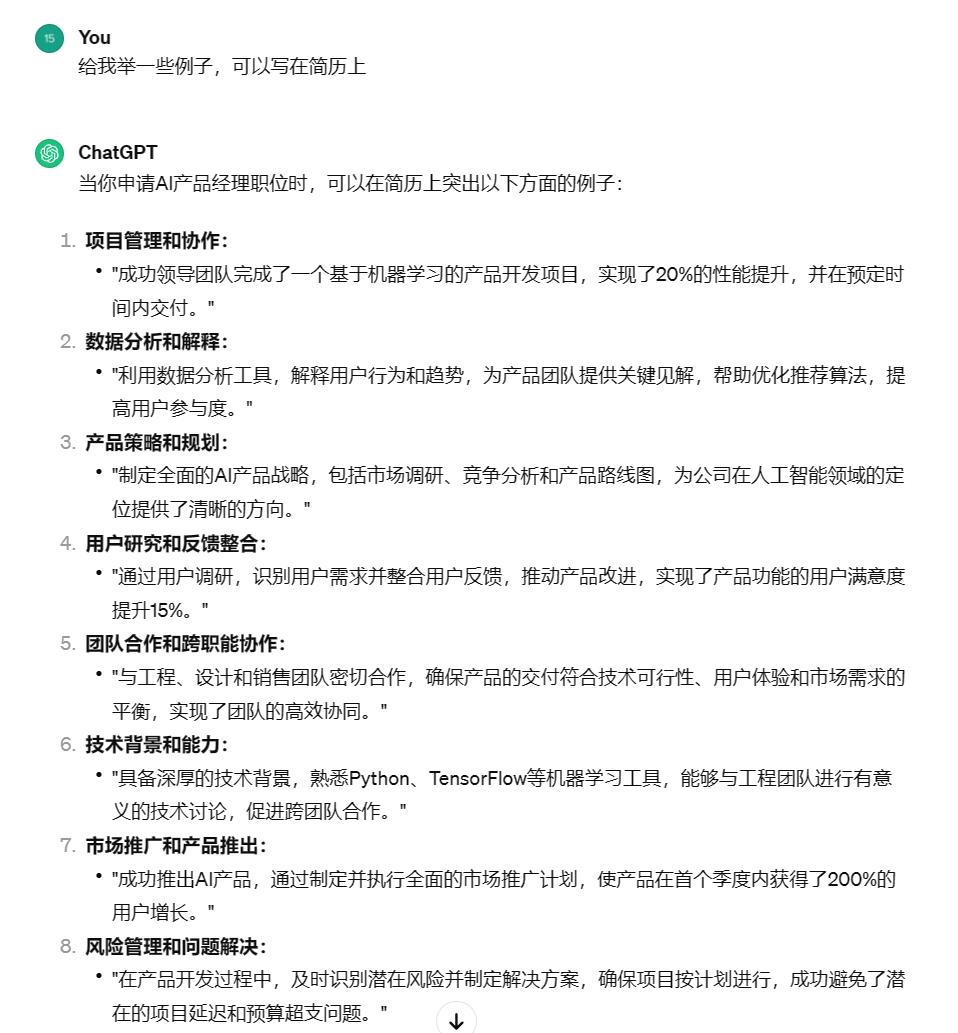

首先,可以向ChatGPT諮詢一下建議,可以看到它會洋洋灑灑給你寫一大堆,包括一些沒什麼用的"個人信息",以及具有參考價值的「工作經驗」「專業技能」等。

接下來,可以讓ChatGPT給你舉幾個例子,如果你恰好有相關的經驗,就可以直接修改。

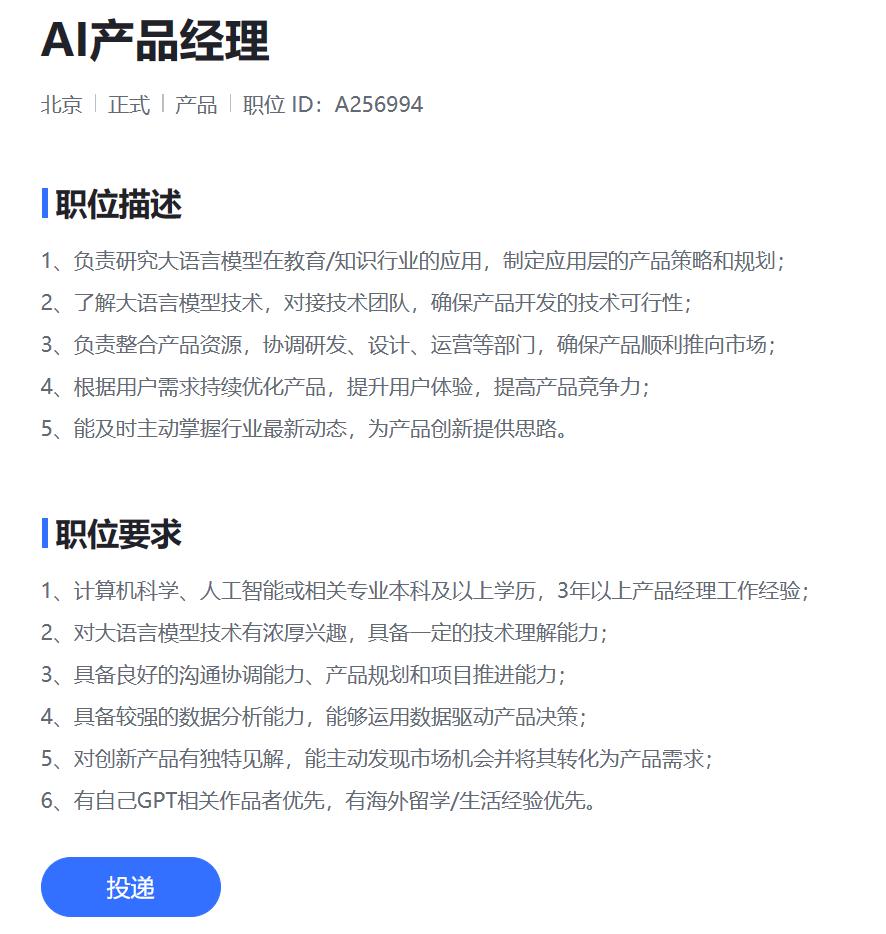

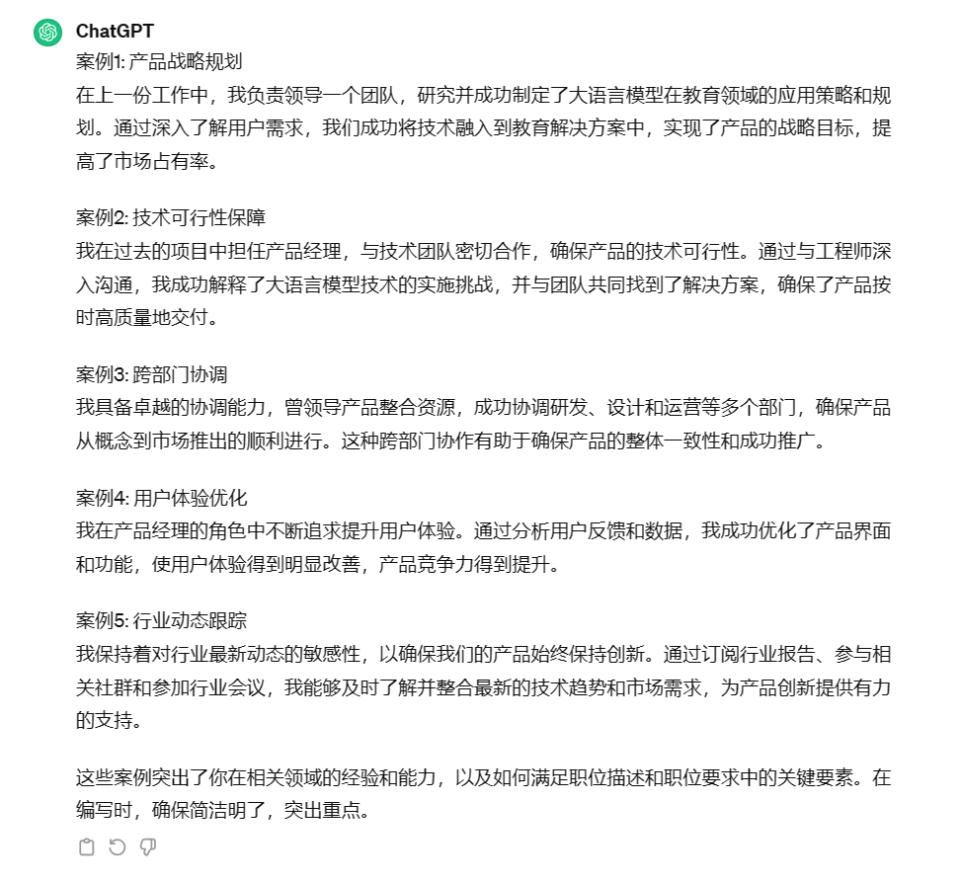

看完參考後,我們可以進入崗位詳情,把職位要求發送給ChatGPT,讓它根據需求,重新寫更加詳細的案例。

當然,矽基君知道你們在想什麼,如何用ChatGPT憑空生成一份簡歷?打鐵還需自身硬,ChatGPT也沒辦法無中生有,生了也不敢用啊。

人類對於偏見和歧視會下意識的進行自我反思,但AI不會,而且更要命的是ChatGPT這樣的黑箱AI,它們偏見往往非常隱蔽,人們很難發現。

早在這一波AI浪潮前,算法就存在歧視的問題。據路透社報導,亞馬遜使用公司十年來收集的簡歷建立了一個篩選算法,但這些簡歷往往來自男性,這個簡歷篩選算法最終學會了歧視女性。

如今算法已經深入我們生活的方方面面和物理規則一樣重要,但算法不會像物理規則那樣平等的對待每一個人。

那麼面對AI的控制,我們能做的也許只有尋找AI的喜好,並不斷的適應它。

全文完。